Spisu treści:

- Autor Lynn Donovan [email protected].

- Public 2024-01-18 08:28.

- Ostatnio zmodyfikowany 2025-01-22 17:36.

Główne parametry konfiguracyjne, które użytkownicy muszą określić w ramach „MapReduce” to:

- Oferty pracy lokalizacje wejściowe w rozproszonym systemie plików.

- Oferty pracy położenie wyjściowe w rozproszonym systemie plików.

- Format wejściowy danych.

- Format wyjściowy danych.

- Klasa zawierająca funkcję mapy.

- Klasa zawierająca funkcję Reduce.

Jakie są tutaj główne parametry konfiguracyjne w programie MapReduce?

Główne parametry konfiguracyjne we frameworku „MapReduce” to:

- Wejściowa lokalizacja zadań w rozproszonym systemie plików.

- Lokalizacja wyjściowa zadań w rozproszonym systemie plików.

- Format wejściowy danych.

- Format wyjściowy danych.

- Klasa zawierająca funkcję map.

- Klasa, która zawiera funkcję Reduce.

Można też zapytać, jakie są parametry maperów i reduktorów? Cztery parametry maperów to:

- Długozapisywalny (dane wejściowe)

- Wprowadzanie tekstu)

- tekst (wyjście pośrednie)

- IntWritable (wyjście pośrednie)

Pytanie brzmi również, jakie są główne elementy zadania MapReduce?

- Główna klasa sterownika, która dostarcza parametry konfiguracyjne zadania.

- Klasa Mapper, która musi rozszerzać org. Apache. hadoop. mapredukcja. Mapper klasy i zapewniają implementację metody map().

- Klasa reduktora, która powinna rozszerzać org. Apache. hadoop. mapredukcja. Klasa reduktora.

Co to jest partycjonowanie i jak pomaga w procesie pracy MapReduce?

Partycjonowanie w MapaZmniejsz pracę wykonanie kontroluje partycjonowanie kluczy pośrednich map-wyjść. Z Wsparcie funkcji skrótu, klucz (lub podzbiór klucza) wyprowadza przegroda . Rekordy, które mają tę samą wartość klucza, trafiają do tego samego przegroda (w ramach każdego mapera).

Zalecana:

Jak zabić zadanie MapReduce?

Hadoop job -kill job_id i przędza application -kill application_id oba polecenia służą do zabicia zadania uruchomionego na Hadoop. Jeśli używasz MapReduce Version1 (MR V1) i chcesz zabić zadanie uruchomione na Hadoop, możesz użyć zadania hadoop -kill job_id , aby zabić zadanie i zabije wszystkie zadania (zarówno uruchomione, jak i w kolejce)

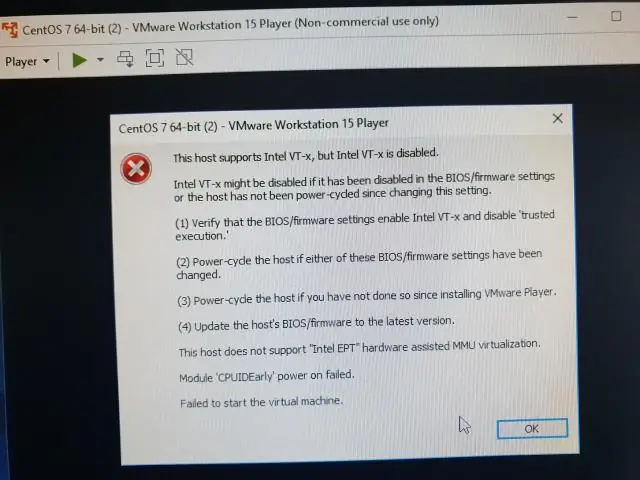

Jakie opcje muszą być włączone, aby uruchomić Hyper V?

Pytanie 2 Jakie opcje sprzętowe muszą być włączone, aby uruchomić Hyper-V? Aby uruchomić Hyper-V, należy włączyć opcję wirtualizacji sprzętu (Intel VT/AMD-V) i Zapobieganie wykonywaniu danych (Intel DX/AMD NX)

Jakie są ważne pliki konfiguracyjne, które należy zaktualizować, edytować, aby skonfigurować w pełni rozproszony tryb klastra Hadoop?

Pliki konfiguracyjne, które należy zaktualizować, aby skonfigurować w pełni rozproszony tryb Hadoop, to: Hadoop-env.sh. Główna witryna. xml. Witryna hdfs. xml. Mapred-site. xml. Mistrzowie. Niewolnicy

Jakie są główne elementy zarządzania plikami? Sprawdź wszystkie, które mają zastosowanie?

Głównymi składnikami zarządzania plikami są przechowywanie danych, metadane plików i system plików. Jakie są główne elementy zarządzania plikami? Zaznacz wszystko, co dotyczy. Możesz mieć wiele procesów uruchomionych dla jednego programu

Jak uruchomić dwie główne klasy w Eclipse?

3 odpowiedzi Przejdź do głównej metody każdego programu, aby je uruchomić. Gdy raz je uruchomisz, pojawią się one w menu rozwijanym na przycisku uruchamiania. Zrób wiele konsol i przypnij je. Przenieś wiele konsol do oddzielnych widoków, aby móc je oglądać jednocześnie