- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:51.

- Ostatnio zmodyfikowany 2025-01-22 17:36.

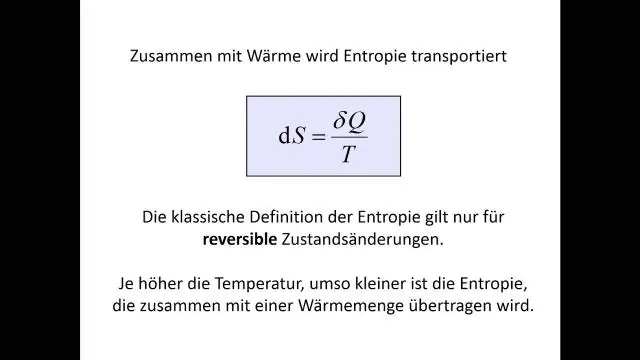

Entropia : A drzewo decyzyjne jest budowany od góry do dołu z węzła głównego i obejmuje partycjonowanie danych na podzbiory, które zawierają instancje o podobnych wartościach (jednorodne). wykorzystuje algorytm ID3 entropia aby obliczyć jednorodność próbki.

Ludzie również pytają, jaka jest definicja entropii w uczeniu maszynowym?

Entropia , jak to się odnosi nauczanie maszynowe , jest miarą losowości przetwarzanych informacji. Im wyższy entropia , tym trudniej wyciągnąć jakiekolwiek wnioski z tych informacji. Rzut monetą to przykład akcji, która dostarcza informacji, które są losowe. To jest istota entropia.

Poza powyższym, czym jest zysk informacji i entropia w drzewie decyzyjnym? ten zdobywanie informacji opiera się na spadku entropia po podzieleniu zestawu danych na atrybucie. Konstruowanie drzewo decyzyjne polega na znalezieniu atrybutu, który zwraca najwyższą wartość zdobywanie informacji (tj. najbardziej jednorodne gałęzie). Rezultatem jest Zdobywanie informacji lub zmniejszyć w entropia.

Wiedz też, jaka jest minimalna wartość entropii w drzewie decyzyjnym?

Entropia jest najniższy w skrajnościach, gdy bańka albo nie zawiera żadnych pozytywnych instancji, albo tylko pozytywne instancje. Oznacza to, że gdy bańka jest czysta, nieporządek wynosi 0. Entropia jest najwyższy w środku, gdy bąbelek jest równomiernie dzielony między instancje dodatnie i ujemne.

Czym jest entropia w losowym lesie?

Co to jest Entropia i dlaczego informacje zyskują na znaczeniu w Decyzja Drzewa? Nasir Islam Sujan. 29 czerwca 2018 · 5 min czytania. Według Wikipedii Entropia odnosi się do nieporządku lub niepewności. Definicja: Entropia jest miarą nieczystości, nieładu lub niepewności w kilku przykładach.

Zalecana:

Jaka jest najlepsza definicja modelu bezpieczeństwa?

Model bezpieczeństwa to techniczna ocena każdej części systemu komputerowego w celu oceny jej zgodności ze standardami bezpieczeństwa. D. Model bezpieczeństwa to proces formalnej akceptacji certyfikowanej konfiguracji

Jaka jest definicja obserwacji jakościowych i ilościowych?

Polega na obserwacji wszystkiego, co można zmierzyć, np. różnic w kształtach, rozmiarach, kolorze, objętości i liczbach. Obserwacja jakościowa to subiektywny proces gromadzenia danych lub informacji, podczas gdy obserwacja ilościowa jest obiektywnym procesem gromadzenia danych lub informacji

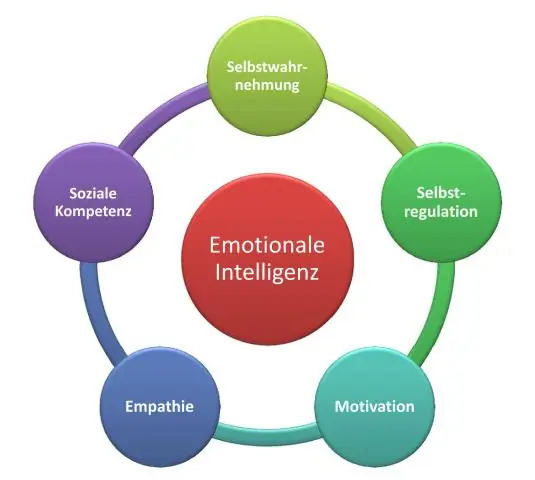

Jaka jest definicja inteligencji w psychologii?

Inteligencja to umiejętność myślenia, uczenia się na doświadczeniach, rozwiązywania problemów i dostosowywania się do nowych sytuacji. Psychologowie uważają, że istnieje konstrukcja, znana jako inteligencja ogólna (g), która odpowiada za ogólne różnice w inteligencji między ludźmi

Co to jest węzeł w drzewie decyzyjnym?

Drzewo decyzyjne jest strukturą podobną do schematu blokowego, w której każdy węzeł wewnętrzny reprezentuje „test” atrybutu (np. czy rzut monetą wypadnie orzeł czy reszka), każda gałąź reprezentuje wynik testu, a każdy węzeł liścia reprezentuje etykieta klasy (decyzja podjęta po obliczeniu wszystkich atrybutów)

Co to jest zysk informacji o entropii?

Zysk informacji = ile usunęliśmy Entropii, więc To ma sens: wyższy zysk informacji = więcej usuniętej Entropii, a tego właśnie chcemy. W idealnym przypadku każda gałąź zawierałaby tylko jeden kolor po podziale, co oznaczałoby zerową entropię