- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:51.

- Ostatnio zmodyfikowany 2025-01-22 17:36.

W kategoriach laika, samego siebie - Uwaga mechanizm pozwala wejść na interakcję ze sobą („ samego siebie ”) i dowiedz się, komu powinni zapłacić więcej Uwaga do ( Uwaga ”). Wyjścia są agregaty tych interakcji i Uwaga wyniki.

Co to jest samouważność?

Samego siebie - Uwaga , czasami nazywany intra- Uwaga jest Uwaga mechanizm odnoszący się do różnych pozycji pojedynczej sekwencji w celu obliczenia reprezentacji sekwencji.

Co to jest samouważność w głębokim uczeniu się? Najpierw zdefiniujmy, co „ samego siebie - Uwaga jest. Cheng i wsp. w swoim artykule zatytułowanym „Long-Short-Term Memory-Networks for Maszyna Czytanie”, zdefiniowano samego siebie - Uwaga jako mechanizm powiązania różnych pozycji pojedynczej sekwencji lub zdania w celu uzyskania bardziej wyrazistej reprezentacji.

W związku z tym, czym jest mechanizm uwagi?

Mechanizm uwagi umożliwia dekoderowi zajmowanie się różnymi częściami zdania źródłowego na każdym etapie generowania danych wyjściowych. Zamiast kodować sekwencję wejściową w pojedynczy stały wektor kontekstu, pozwalamy modelowi nauczyć się, jak generować wektor kontekstu dla każdego wyjściowego kroku czasowego.

Czym jest model oparty na uwadze?

Uwaga - modele oparte należą do klasy modele powszechnie nazywany sekwencją do sekwencji modele . Celem tych modele , jak sama nazwa wskazuje, tworzy sekwencję wyjściową o podanej sekwencji wejściowej, która na ogół ma różne długości.

Zalecana:

Jak działa proxy Spring AOP?

Proxy AOP: obiekt stworzony przez framework AOP w celu zaimplementowania kontraktów aspektu (doradzanie wykonania metod itd.). W Spring Framework, proxy AOP będzie dynamicznym proxy JDK lub proxy CGLIB. Tkactwo: łączenie aspektów z innymi typami aplikacji lub obiektami w celu stworzenia zalecanego obiektu

Jak działa telewizor lustrzany?

Telewizor lustrzany składa się ze specjalnego półprzezroczystego szkła lustrzanego z telewizorem LCD za lustrzaną powierzchnią. Lustro jest starannie spolaryzowane, aby umożliwić przechodzenie obrazu przez lustro, tak że gdy telewizor jest wyłączony, urządzenie wygląda jak lustro

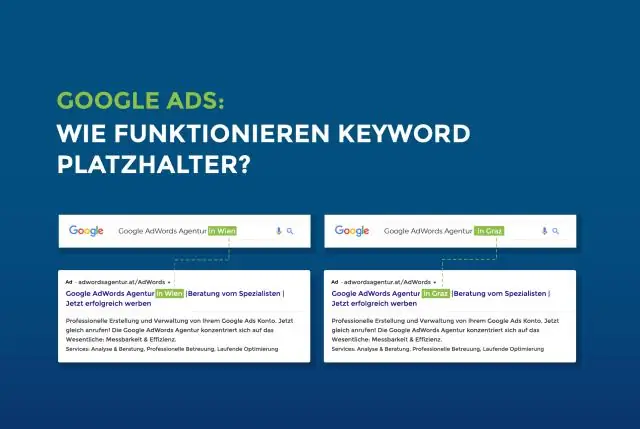

Jak działa symbol zastępczy?

Atrybut placeholder określa krótką wskazówkę opisującą oczekiwaną wartość pola wejściowego (np. przykładową wartość lub krótki opis oczekiwanego formatu). Uwaga: Atrybut placeholder działa z następującymi typami danych wejściowych: tekst, wyszukiwanie, url, tel, e-mail i hasło

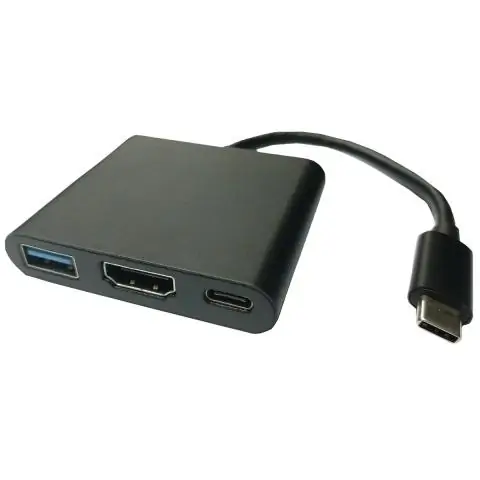

Jak działa adapter wyświetlacza USB?

Karty wideo USB to urządzenia, które mają jeden port USB i łączą się z jednym lub wieloma złączami wideo, takimi jak VGA, DVI, HDMI lub DisplayPort. Jest to przydatne, jeśli chcesz dodać dodatkowy wyświetlacz do konfiguracji komputera, ale nie masz połączeń wideo na komputerze

Jak działa kod korekcji błędów?

Kod korekcji błędów to algorytm wyrażania sekwencji liczb w taki sposób, że wszelkie wprowadzone błędy można wykryć i poprawić (z pewnymi ograniczeniami) na podstawie pozostałych liczb. Badanie kodów korygujących błędy i związanej z nimi matematyki jest znane jako teoria kodowania