- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:51.

- Ostatnio zmodyfikowany 2025-01-22 17:36.

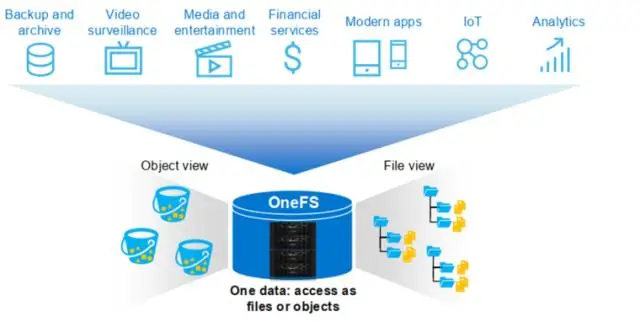

S3 jest w rzeczywistości nieskończoną pamięcią masową w chmurze, ale HDFS nie jest. HDFS jest hostowany na komputerach fizycznych, więc możesz tam wykonać dowolny program. Nie możesz wykonać niczego na S3 jako tylko Object Store, a nie FS.

Czy zatem s3 jest rozproszonym systemem plików?

S3 nie jest rozproszony system plików . Jest to binarny magazyn obiektów, który przechowuje dane w parach klucz-wartość. Jest to zasadniczo rodzaj bazy danych NoSQL. Każdy zasobnik to nowa „baza danych”, w której klucze są „ścieżką do folderu”, a wartości są obiektami binarnymi ( pliki ).

Można też zapytać, czy AWS opiera się na Hadoop? Hadoop to platforma, która pomaga przetwarzać duże zestawy danych na wielu komputerach. Obejmuje Map/Reduce (przetwarzanie równoległe) i HDFS (rozproszony system plików). AWS jest hurtownią danych wybudowany w oparciu o zastrzeżoną technologię pierwotnie opracowaną przez ParAccel.

Poza tym, jak przenieść pliki z s3 do HDFS?

Odpowiedź. Nie ma bezpośredniego sposób na kopiowanie plików z S3 do HDFS bez przechodzenia przez lokalne pliki . Możesz jednak użyć komponentu tSystem w standardowym zadaniu, aby wywołać natywne Hadoop polecenie, którego zwykle używasz do kopiuj pliki , na przykład, s3 -odst-cp.

Co to jest baza danych s3?

Amazonka S3 lub Amazon Simple Storage Service to usługa oferowana przez Amazon Web Services (AWS), która zapewnia obiektową pamięć masową za pośrednictwem interfejsu usługi sieciowej. Amazonka S3 korzysta z tej samej skalowalnej infrastruktury pamięci masowej, której Amazon.com używa do prowadzenia swojej globalnej sieci e-commerce.

Zalecana:

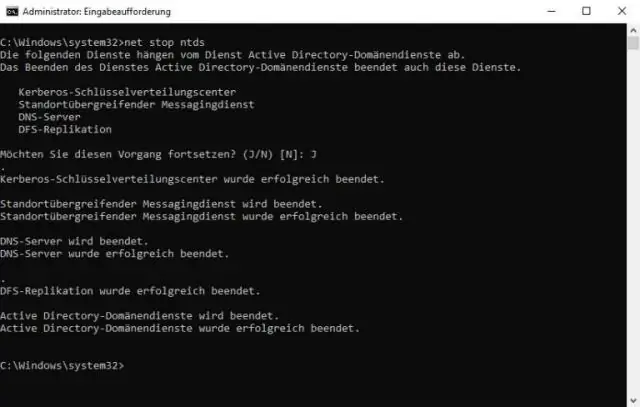

Jak przenieść z HDFS do lokalnego?

Możesz skopiować dane z hdfs do lokalnego systemu plików na dwa sposoby: bin/hadoop fs -get /hdfs/source/path /localfs/destination/path. bin/hadoop fs -copyToLocal /hdfs/źródło/ścieżka /localfs/miejsce docelowe/ścieżka

Czy bazuje na SDL Tridion.net?

Ocena: 3/5 SDL Tridion R5 działa w obu Microsoft. Środowiska NET i Java/J2EE za pośrednictwem WebServices przy użyciu protokołu SOAP. API: SDL Tridion R5 obsługuje API Java i COM. Ten ostatni to tak naprawdę TOM (Tridion ObjectModel), oparty na COM

Czym jest równoważenie w HDFS?

HDFS zapewnia narzędzie równoważące. To narzędzie analizuje rozmieszczenie bloków i równoważy dane w DataNodes. Przenosi bloki, dopóki klaster nie zostanie uznany za zrównoważony, co oznacza, że wykorzystanie każdego DataNode jest jednolite

Jak utworzyć katalog w HDFS DFS?

Utwórz katalog w HDFS. Sposób użycia: $ hdfs dfs -mkdir Wyświetla zawartość katalogu w HDFS. Prześlij plik do HDFS. Pobierz plik z HDFS. Sprawdź stan pliku w HDFS. Zobacz zawartość pliku w HDFS. Skopiuj plik ze źródła do miejsca docelowego w HDFS. Skopiuj plik z/do lokalnego systemu plików do HDFS

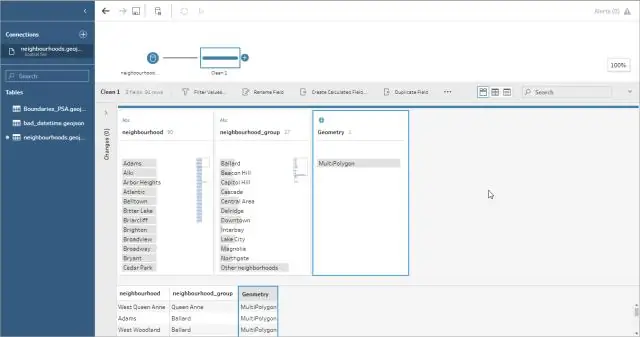

Czy Tableau może połączyć się z HDFS?

Łączniki natywne ułatwiają łączenie Tableau z Hadoop bez potrzeby specjalnej konfiguracji - Hadoop to tylko kolejne źródło danych dla Tableau. Przenieś dane do szybkiego, wbudowanego w pamięć silnika analitycznego do szybkich zapytań lub użyj połączenia na żywo z własną wydajną bazą danych