- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:51.

- Ostatnio zmodyfikowany 2025-06-01 05:10.

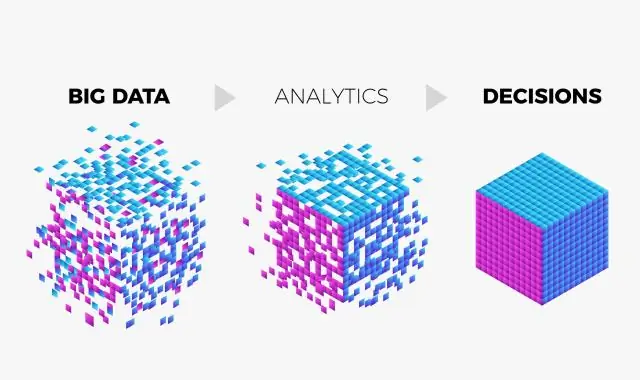

Analiza dużych zbiorów danych jest często złożonym procesem badania duży i zróżnicowane dane zestawy, lub duże dane , aby odkryć informacje - takie jak ukryte wzorce, nieznane korelacje, trendy rynkowe i preferencje klientów - które mogą pomóc organizacjom w podejmowaniu świadomych decyzji biznesowych.

W związku z tym, czego wymaga analiza big data?

1) Programowanie Niewiele standardowych procesów jest ustawionych wokół dużych złożonych zbiorów danych a analityk dużych zbiorów danych ma do czynienia. Wiele dostosowań jest wymagany na co dzień radzić sobie z nieustrukturyzowanymi dane . Jakie języki są wymagany - R, Python, Java, C++, Ruby, SQL, Hive, SAS, SPSS, MATLAB, Weka, Julia, Scala.

Poza powyższym, dlaczego potrzebujemy analizy big data? Analiza dużych zbiorów danych to proces wydobywania przydatnych informacji poprzez analizę różnych typów duże zbiory danych zestawy. Analiza dużych zbiorów danych służy do odkrywania ukrytych wzorców, trendów rynkowych i preferencji konsumentów, z korzyścią dla podejmowania decyzji organizacyjnych.

Można też zapytać, jak działa analityka big data?

Big Data pochodzi z tekstu, dźwięku, wideo i obrazów. Big Data jest analizowany przez organizacje i firmy z powodów takich jak odkrywanie wzorców i trendów związanych z ludzkimi zachowaniami i naszą interakcją z technologią, które mogą być następnie wykorzystane do podejmowania decyzji mających wpływ na nasz sposób życia, Praca , i gra.

Czym dokładnie jest analiza danych?

Analityka danych odnosi się do technik i procesów jakościowych i ilościowych stosowanych w celu zwiększenia wydajności i zysków biznesowych. Dane jest wyodrębniony i skategoryzowany w celu identyfikacji i analizy behawioralnej dane i wzorce, i techniki różnią się w zależności od wymagań organizacyjnych.

Zalecana:

Jakie procesy są wykorzystywane do wykrywania trendów w dużych zestawach danych?

Dane źródłowe muszą przejść przez proces zwany etapowaniem danych i zostać wyodrębnione, ponownie sformatowane, a następnie przechowywane w hurtowni danych. Jakie procesy są wykorzystywane do wykrywania trendów w dużych zestawach danych? Eksploracja danych służy do analizowania dużych ilości danych w celu identyfikacji trendów

Jak korzystać ze zbiorów Google?

Dodawanie elementów do kolekcji Na telefonie lub tablecie z Androidem wejdź na Google.com lub otwórz aplikację Google. Zaloguj się na swoje konto Google, jeśli jeszcze tego nie zrobiłeś. Przeprowadź wyszukiwanie. Kliknij wynik, który chcesz zapisać. U góry kliknij Dodaj do. Przedmiot zostanie dodany do Twojej najnowszej kolekcji

Jak NoSQL odnosi się do dużych zbiorów danych?

NoSQL to technologia baz danych napędzana przez Cloud Computing, Internet, Big Data i Big Users. NoSQL generalnie skaluje się w poziomie i unika poważnych operacji łączenia na danych. Bazę danych NoSQL można nazwać uporządkowaną pamięcią masową, która składa się z relacyjnej bazy danych jako podzbioru

Co to jest przypadek użycia w dużych zbiorach danych?

Chociaż większość przypadków użycia dużych zbiorów danych dotyczy przechowywania i przetwarzania danych, obejmują one wiele aspektów biznesowych, takich jak analityka klienta, ocena ryzyka i wykrywanie oszustw. Dzięki temu każda firma może znaleźć odpowiedni przypadek użycia, aby zaspokoić swoje szczególne potrzeby

Co to jest rozwiązanie NoSQL do obsługi dużych zbiorów danych?

Celem korzystania z bazy danych NoSQL jest przechowywanie rozproszonych magazynów danych o ogromnych potrzebach w zakresie przechowywania danych. NoSQL służy do obsługi Big Data i aplikacji internetowych czasu rzeczywistego. Zamiast tego system baz danych NoSQL obejmuje szeroką gamę technologii baz danych, które mogą przechowywać dane strukturalne, częściowo ustrukturyzowane, nieustrukturyzowane i polimorficzne